14. 将事情做正确

将世界的美好、丑陋与残酷一起喂给 AI,却期待它只反映美好的一面,这是一种幻想。

Vinay Uday Prabhu 与 Abeba Birhane,《Large Datasets: A Pyrrhic Win for Computer Vision?》(2020)

在本书最后一章,让我们退一步看问题。整本书里,我们考察了各种数据系统架构,评估了它们的利弊,也探讨了如何构建可靠、可伸缩、可维护的应用。然而,我们一直略去了讨论中一个重要而基础的部分,现在该补上了。

每个系统都是为了某种目的而建;我们做的每个动作,都有预期后果,也有非预期后果。目的可能只是赚钱,但对世界产生的影响可能远远超出这个初始目的。构建这些系统的工程师,有责任认真思考这些后果,并且有意识地决定我们希望生活在怎样的世界中。

我们常把数据当成抽象事物来谈论,但请记住,许多数据集都是关于人的:他们的行为、兴趣、身份。我们必须以人性与尊重来对待这样的数据。用户也是人,而人的尊严至高无上 1。

软件开发越来越涉及重要的伦理抉择。确实有一些指南帮助软件工程师应对这些问题,比如 ACM《伦理与职业行为准则》 2,但在实践中,它们很少被讨论、应用与执行。因此,工程师和产品经理有时会对隐私以及产品可能带来的负面后果抱持一种轻率态度 3, 4。

技术本身并无善恶,关键在于它如何被使用,以及它如何影响人。这一点对搜索引擎这样的软件系统成立,对枪支这样的武器同样成立。软件工程师若只专注技术本身而忽视其后果,是不够的:伦理责任同样由我们承担。伦理推理很难,但它又重要到不能回避。

不过,什么算“好”或“坏”并没有清晰定义,而计算领域的大多数人甚至不讨论这个问题 5。与计算领域中的很多概念不同,伦理的核心概念并没有严格且确定的单一含义,它们需要解释,而解释可能具有主观性 6。伦理并不是走一遍检查清单、确认你“合规”就完事;它是一种参与式、迭代式的反思过程,要与相关人群对话,并对结果负责 7。

预测分析

例如,预测分析是人们对大数据和 AI 感到兴奋的重要原因之一。用数据分析来预测天气或疾病传播是一回事 8;预测一个罪犯是否可能再犯、一个贷款申请者是否可能违约,或一个保险客户是否可能提出高额理赔,又是另一回事 9。后者会直接影响个人的生活。

支付网络当然想防止欺诈交易,银行想避免坏账,航空公司想避免劫机,公司想避免雇到低效或不可信的人。从它们的角度看,错过一笔业务机会的成本较低,而坏账或问题员工的成本更高,因此机构倾向于谨慎行事完全可以理解。拿不准时,说“不”更稳妥。

然而,随着算法决策越来越普遍,一个被某个算法标记为“高风险”的人(不管标记准确与否),可能会不断遭遇这种“不”。如果一个人系统性地被排除在工作、航空出行、保险保障、房屋租赁、金融服务以及社会其他关键领域之外,这对个体自由构成的约束之大,以至于有人称之为“算法监狱” 10。在尊重人权的国家,刑事司法讲究“未经证明有罪即推定无罪”;但自动化系统却可能在没有罪证、几乎无申诉机会的情况下,系统性且任意地把一个人排除在社会参与之外。

偏见与歧视

算法作出的决策并不必然比人更好,也不必然更差。每个人都可能有偏见,即使他们主动尝试纠偏也是如此;歧视性做法也可能被文化性地制度化。人们期待基于数据、而非基于人的主观直觉评估来作决定,可能更公平,也能让传统系统中常被忽视的人获得更好机会 11。

当我们开发预测分析和 AI 系统时,我们并不只是把人的决策“自动化”——即用软件写明何时说“是”或“否”的规则;我们甚至把规则本身也交给数据去推断。然而,这些系统学到的模式往往是不透明的:即使数据中存在某种相关性,我们也未必知道为什么。如果算法输入中存在系统性偏差,系统很可能会在输出中学习并放大这种偏差 12。

在许多国家,反歧视法禁止依据族裔、年龄、性别、性取向、残障或信仰等受保护特征而区别对待他人。一个人的其他数据特征也许可以分析,但如果这些特征与受保护特征相关怎么办?例如,在按种族隔离的社区里,一个人的邮编,甚至其 IP 地址,都可能是种族的强预测因子。这样一看,认为算法能把带偏见的数据作为输入,却产出公平中立的结果,几乎是荒谬的 13, 14。然而,数据驱动决策的支持者常隐含这种信念,这种态度甚至被讽刺为“机器学习就像给偏见洗钱” 15。

预测分析系统只是在外推过去;如果过去有歧视,它们就会把歧视编码并放大 16。如果我们希望未来比过去更好,就需要道德想象力,而这只能由人提供 17。数据和模型应当是我们的工具,而不是我们的主宰。

责任与问责

自动化决策把责任与问责问题摆到了台前 17。如果人犯了错,可以追责,受影响者也可以申诉。算法同样会出错,但如果算法出了问题,谁来负责 18?自动驾驶汽车造成事故,谁应承担责任?自动化信用评分算法如果系统性歧视某一族裔或宗教的人,受害者是否有救济途径?如果你的机器学习系统的决策受到司法审查,你能向法官解释算法是如何作出该决策的吗?人不应通过“怪算法”来逃避自己的责任。

信用评级机构是一个较早的先例:通过收集数据来对人作决策。糟糕的信用评分会让生活变难,但至少信用分通常基于与借贷历史直接相关的事实记录,记录中的错误也可以更正(尽管机构往往不会让这件事变得容易)。相比之下,基于机器学习的评分算法通常使用更广泛的输入且更不透明,使人更难理解某个具体决策是如何得出的,也更难判断某人是否受到了不公平或歧视性对待 19。

信用分回答的是“你过去行为如何?”;而预测分析通常基于“谁和你相似,以及像你这样的人过去行为如何?”。把某人和“相似人群”类比,本质上就是在给人贴群体标签,比如按居住地(这往往是种族和社会经济阶层的近似代理)来推断。那被分错桶的人怎么办?此外,如果决策因错误数据而出错,几乎不可能得到救济 17。

许多数据本质上是统计性的,这意味着即便总体概率分布正确,具体个案也可能是错的。比如,某国平均预期寿命是 80 岁,并不意味着你会在 80 岁生日那天去世。仅凭平均值和概率分布,我们很难判断某个具体个体会活到多少岁。同样,预测系统的输出是概率性的,在具体个案上完全可能出错。

盲目相信数据在决策中的至高地位,不仅是错觉,更是危险。随着数据驱动决策越来越普遍,我们必须找到办法让算法可问责、可透明,避免强化既有偏见,并在它们不可避免地犯错时加以纠正。

我们还需要想办法防止数据被用来伤害人,并实现其积极潜力。比如,分析可以揭示一个人财务和社会生活上的特征。一方面,这种能力可以用于把援助精准地送到最需要的人手中。另一方面,它有时被掠夺性企业用来识别脆弱人群,并向其兜售高成本贷款、含金量极低的学历项目等高风险产品 17, 20。

反馈回路

即便在对人影响没那么立竿见影的预测应用中,比如推荐系统,我们也必须直面棘手问题。当服务越来越擅长预测用户想看什么内容时,它可能最终只向人们展示他们本就认同的观点,形成回音室,让刻板印象、错误信息和社会极化不断滋生。我们已经看到社交媒体回音室对选举活动的影响。

当预测分析影响人的生活时,自我强化的反馈回路会带来尤其恶性的后果。比如,设想雇主用信用分来评估候选人。你原本是一个工作能力不错、信用也不错的人,但因某个无法控制的不幸事件突然陷入财务困境。账单逾期后,你的信用分下降,找到工作的可能性也随之下降。失业把你推向贫困,反过来让你的评分更差,进一步降低就业机会 17。这就是一种下行螺旋:有毒假设披着数学严谨与数据客观的伪装。

反馈回路还有另一个例子:经济学家发现,德国加油站引入算法定价后,竞争反而减弱,消费者价格上升,因为算法学会了“合谋” 21。

我们并不总能预测这些反馈回路何时出现。不过,很多后果可以通过思考“整个系统”来预见(不仅是计算机化部分,还包括与系统交互的人)——这种方法称为 系统思维 22。我们可以尝试理解数据分析系统对不同行为、结构与特征的响应。系统是在强化和放大人与人之间既有差异(例如让富者更富、穷者更穷),还是在努力对抗不公?而且,即便出发点再好,我们也必须警惕非预期后果。

隐私与追踪

除了预测分析的问题——也就是用数据自动化地对人作决策——数据收集本身也有伦理问题。收集数据的组织,与数据被收集的人之间,到底是什么关系?

当系统只存储用户明确输入的数据,因为用户希望系统以某种方式存储和处理它时,系统是在为用户提供服务:用户是客户。但当用户活动是在做其他事情时被“顺带”追踪并记录下来,这种关系就不那么清晰了。服务不再只是执行用户指令,而开始拥有自己的利益,而这种利益可能与用户利益冲突。

行为数据追踪已成为许多在线服务面向用户功能的重要组成部分:追踪搜索结果点击有助于改进搜索排序;推荐“喜欢 X 的人也喜欢 Y”可帮助用户发现有趣且有用的内容;A/B 测试与用户流程分析可帮助改进用户界面。这些功能都需要一定程度的用户行为追踪,用户也能从中受益。

然而,取决于公司的商业模式,追踪往往不会止步于此。如果服务靠广告资助,那么广告主才是真正客户,用户利益就会退居次位。追踪数据会变得更细、分析会更深入、数据会被长期保留,以便为营销目的构建每个人的精细画像。

这时,公司与被收集数据的用户之间的关系,就开始显著改变了。用户得到“免费”服务,并被引导尽可能多地参与。对用户的追踪,主要服务的并不是这个个体,而是资助服务的广告主需求。这样的关系,用一个语义更阴暗的词来描述更贴切:监视。

监视

做个思想实验:把 data 一词替换为 surveillance(监视),看看常见说法是否还那么“好听” 23。例如:“在我们这个监视驱动的组织中,我们收集实时监视流并存入监视仓库。我们的监视科学家使用先进的分析与监视处理来产出新洞见。”

这个思想实验对本书来说少见地带有一点论战色彩,仿佛书名成了《设计监视密集型应用》(Designing Surveillance-Intensive Applications)。但为了强调这一点,我们需要更尖锐的词。在我们试图让软件“吞噬世界” 24 的过程中,我们构建了人类有史以来规模最大的群体监视基础设施。我们正快速接近这样一个世界:几乎每个有人居住的空间都至少有一个联网麦克风,存在于智能手机、智能电视、语音助手设备、婴儿监视器,甚至使用云语音识别的儿童玩具中。许多这类设备的安全记录都非常糟糕 25。

与过去相比,新变化在于:数字化让大规模收集人的数据变得很容易。对我们位置与行动轨迹、社交关系与通信、购买与支付、健康信息的监视,几乎已不可避免。一个监视型组织最终掌握的个人信息,甚至可能比当事人自己知道的还多——例如,在当事人意识到之前就识别出其疾病或经济困境。

即便是过去最极权、最压迫的政权,也只能梦想把麦克风装进每个房间,并迫使每个人随身携带可追踪其位置与行动的设备。可是,由于数字技术带来的好处太大,我们如今却自愿接受这个全面监视的世界。区别只在于:数据由企业收集以向我们提供服务,而不是由政府机构为控制目的而收集 26。

并非所有数据收集都一定构成监视,但把它放在“监视”的框架下审视,有助于我们理解自己与数据收集者的关系。为什么我们似乎乐于接受企业监视?也许你觉得自己“没什么可隐瞒”——换句话说,你与既有权力结构完全一致,不是边缘少数群体,也无需担心被迫害 27。但不是每个人都这么幸运。又或者,你觉得目的似乎是善意的——不是公开的强制和驯化,而只是更好的推荐与更个性化的营销。然而,结合上一节对预测分析的讨论,这种区分就没那么清楚了。

我们已经看到,汽车在未经驾驶员同意的情况下追踪其驾驶行为,并影响保险费率 28;也看到了与佩戴健身追踪设备绑定的健康保险保障。当监视被用于决定对生活关键方面有重大影响的事项(如保险保障或就业)时,它看起来就不再“无害”。而且,数据分析还能揭示极具侵入性的内容:例如,智能手表或健身手环里的运动传感器可以以相当高的准确率推断你在输入什么(包括密码) 29。传感器精度和分析算法只会越来越强。

同意与选择自由

我们或许会主张,用户是自愿选择使用会追踪其活动的服务,并且他们同意了服务条款和隐私政策,因此他们已同意数据收集。我们甚至可能声称,用户正以其提供的数据换取有价值的服务,而追踪是提供该服务所必需的。毫无疑问,社交网络、搜索引擎和各种其他免费在线服务确实对用户有价值——但这个论证有问题。

首先,我们应当问:追踪在哪种意义上是“必要的”?有些追踪形式确实直接用于改进用户功能:例如,追踪搜索结果点击率可提升搜索排序与相关性;追踪客户常一起购买哪些商品,可帮助网店推荐关联商品。然而,当追踪用户交互是为了内容推荐,或为了广告构建用户画像时,这是否真正在用户利益之中就不那么清楚了——还是说,它“必要”仅仅因为广告在为服务买单?

其次,用户对自己向我们的数据库“喂入”了哪些数据、这些数据如何被保留与处理,几乎没有认知——而多数隐私政策更多是在遮蔽而非阐明。用户若不了解其数据会发生什么,就无法给出有意义的同意。并且,某个用户的数据往往也会揭示并非该服务用户、也未同意任何条款的其他人。我们在本书这部分讨论过的那些派生数据集——其中可能把全体用户数据与行为追踪及外部数据源结合——正是用户不可能形成有意义理解的数据类型。

此外,数据从用户身上被抽取是单向过程,不是具有真实互惠的关系,也不是公平的价值交换。这里没有对话,没有让用户协商“提供多少数据、换取什么服务”的空间:服务与用户之间的关系高度不对称、单向度。规则由服务制定,而非用户 30, 31。

在欧盟,《通用数据保护条例》(GDPR)要求同意必须是 “freely given, specific, informed, and unambiguous”,并且用户必须能够 “refuse or withdraw consent without detriment”——否则不被视为 “freely given”。任何征求同意的请求都必须以 “an intelligible and easily accessible form, using clear and plain language” 撰写。此外,“silence, pre-ticked boxes or inactivity

constitute consent” 32。除同意外,个人数据处理还可基于其他合法基础,例如 legitimate interest,它允许某些数据用途,如防欺诈 33。

你可能会说,不同意被监视的用户可以选择不用这项服务。但这种选择同样不自由:如果某项服务流行到“被大多数人视为基本社会参与所必需” 30,那就不能合理期待人们退出——使用它在事实上成了强制(de facto mandatory)。例如,在多数西方社群中,携带智能手机、通过社交网络社交、使用 Google 获取信息,已经成为常态。尤其当服务具有网络效应时,选择 不 使用它会付出社会成本。

因为追踪政策而拒绝使用某服务,说起来容易做起来难。这些平台本来就是为吸引用户而设计的。许多平台使用游戏机制和赌博常见策略来让用户反复回来 34。即便用户能克服这一点,拒绝参与也往往只是少数特权人群的选项:他们有时间和知识去理解隐私政策,也有能力承担潜在代价——比如错过本可通过该服务获得的社会参与或职业机会。对于处境更不利的人来说,并不存在真正意义上的选择自由:监视变得无可逃避。

隐私与数据使用

有时有人声称“隐私已死”,理由是某些用户愿意在社交媒体上发布各种生活内容,有些琐碎,有些极度私密。但这个说法是错误的,它建立在对 privacy 一词的误解之上。

拥有隐私并不意味着把一切都保密;它意味着拥有选择自由:哪些内容向谁披露、哪些公开、哪些保密。隐私权是一种决策权:它让每个人在每种情境中,决定自己在“保密”与“透明”光谱上的位置 30。这是个体自由与自主性的重要组成部分。

例如,一个患有罕见疾病的人,可能非常愿意把其私密医疗数据提供给研究者,只要这有助于开发治疗方法。但关键在于,这个人应当有权选择谁可以访问这些数据,以及出于什么目的。如果其病情信息可能损害其医疗保险、就业或其他重要权益,这个人很可能会更谨慎地共享数据。

当数据通过监视基础设施从人们身上被抽取时,被侵蚀的未必是隐私权本身,而可能是隐私权的转移:转移给数据收集者。获取数据的公司本质上是在说“相信我们会正确使用你的数据”,这意味着决定“披露什么、保密什么”的权利,从个人转移到了公司。

这些公司反过来会把监视结果中的很大一部分保密,因为一旦公开,会让人感到毛骨悚然,并伤害其商业模式(该模式依赖于“比其他公司更了解你”)。关于用户的私密信息通常只以间接方式被暴露,例如通过向特定人群(如患有某种疾病的人)定向投放广告的工具表现出来。

即便特定用户无法从某条广告所面向的人群桶中被个人重识别,他们仍失去了对某些私密信息披露的主导权。决定“向谁披露什么”不再基于用户自己的偏好,而是公司在行使这种隐私权,目标是利润最大化。

许多公司追求的目标是“不被 感知 为令人不适”,回避“数据收集到底有多侵入”这一问题,转而专注于管理用户感知。而且就连这种感知管理也常常做得不好:例如,某些内容也许在事实层面是正确的,但若会触发痛苦记忆,用户可能并不想被提醒 35。面对任何数据,我们都应预期它可能出错、不可取或在某些情况下不合适,并且需要构建机制来处理这些失效。至于什么算“不可取”或“不合适”,当然属于人的判断;算法除非被我们显式编程去尊重人的需要,否则对这些概念是无感的。作为这些系统的工程师,我们必须保持谦逊,接受并预先规划这些失效。

在线服务里的隐私设置,允许用户控制其数据的哪些方面可被其他用户看到,这是把部分控制权还给用户的起点。然而,不管设置如何,服务本身仍可不受限制地访问这些数据,并可在隐私政策允许范围内任意使用。即使服务承诺不把数据出售给第三方,通常也会赋予自己在内部处理和分析数据的广泛权利,而这种处理常常远远超出用户可见范围。

这种把隐私权从个人大规模转移到企业的现象,在历史上前所未有 30。监视并非从未存在,但过去它昂贵且依赖人工,不具备自动化与可伸缩性。信任关系也一直存在,比如病人与医生、被告与律师之间——但这些关系中的数据使用长期受伦理、法律与监管约束。互联网服务则让“在缺乏有意义同意的情况下聚合海量敏感信息,并在用户不知情时以大规模方式使用”变得容易得多。

数据作为资产与权力

由于行为数据是用户与服务交互的副产物,它有时被称为 “data exhaust”(数据尾气),暗示这些数据是无价值的废料。照这个角度看,行为分析与预测分析像一种“回收”,从原本会被丢弃的数据中提炼价值。

更准确的看法可能正相反:从经济学角度看,如果定向广告在为服务买单,那么生成行为数据的用户活动就可被视作一种劳动 36。甚至可以更进一步主张:用户交互的应用本身,只是引诱用户不断向监视基础设施输入更多个人信息的手段 30。在线服务中常见的人类创造力与社会关系,被数据抽取机器以冷酷方式利用。

个人数据是有价值资产,这从数据经纪商行业的存在即可见一斑:这是一个在隐秘中运作、颇为灰暗的行业,购买、聚合、分析、推断并转售关于个人的侵入性数据,多数用于营销 20。初创公司的估值常以用户数、以“眼球”为基础——也就是以其监视能力为基础。

因为数据有价值,很多人都想要它。公司当然想要——这本就是它们收集数据的原因。政府也想拿到:通过秘密交易、胁迫、法律强制,或者直接窃取 37。当公司破产时,其收集的个人数据会作为资产被出售。并且,数据很难彻底保护,泄露事件频发得令人不安。

这些观察促使批评者说,数据不只是资产,还是“有毒资产”(toxic asset) 37,或者至少是“危险材料”(hazardous material) 38。也许数据不是“新黄金”、不是“新石油”,而是“新铀” 39。即使我们认为自己有能力防止数据滥用,每次收集数据时也必须权衡收益与其落入错误之手的风险:计算机系统可能被犯罪分子或敌对外国情报机构攻破,数据可能被内部人员泄露,公司可能落入与我们价值观不一致的管理层手中,或国家可能被一个毫无顾忌、会强迫我们交出数据的政权接管。

收集数据时,我们不仅要考虑今天的政治环境,还要考虑未来所有可能的政府。无法保证未来每一届政府都会尊重人权与公民自由,因此,“安装那些未来可能助长警察国家的技术,是糟糕的公民卫生习惯” 40。

正如古老格言所说,“知识就是力量”。而且,“审视他人而避免自身被审视,是最重要的权力形式之一” 41。这正是极权政府追求监视的原因:它赋予其控制人口的力量。今天的科技公司虽未公开追求政治权力,但它们积累的数据与知识依然赋予其对我们生活的巨大影响力,其中很多是隐蔽的,处在公共监督之外 42。

回顾工业革命

数据是信息时代的决定性特征。互联网、数据存储与处理、软件驱动自动化,正在深刻影响全球经济和人类社会。我们的日常生活与社会组织已被信息技术改变,并且在未来几十年很可能继续发生剧烈变化,这很容易让人联想到工业革命 17, 26。

工业革命建立在重大技术与农业进步之上,长期看带来了持续经济增长和生活水平显著改善。但它也伴随严重问题:空气污染(烟尘与化工过程)和水污染(工业与生活废弃物)都触目惊心。工厂主生活奢华,城市工人却常住在恶劣住房里、长时间在严苛条件下劳动。童工普遍存在,包括矿井中危险且低薪的工作。

社会花了很长时间才建立起各种防护措施:环境保护法规、工作场所安全规程、取缔童工、食品卫生检查。毫无疑问,当工厂不再被允许把废弃物排进河里、售卖污染食品、剥削工人时,做生意的成本上升了。但整个社会从这些规制中获益巨大,今天几乎没人愿意回到那之前 17。

正如工业革命有其需要被管理的黑暗面一样,我们向信息时代的过渡也有重大问题,必须正视并解决 43, 44。数据的收集与使用就是其中之一。借用 Bruce Schneier 的话 26:

数据是信息时代的污染问题,而保护隐私是环境挑战。几乎所有计算机都会产生信息。它会长期滞留、不断发酵。我们如何处理它——如何围堵它、如何处置它——对信息经济的健康至关重要。正如今天我们回望工业时代的早期几十年,会疑惑我们的祖先为何在建设工业世界的狂热中忽视了污染问题;我们的后代也将回望信息时代的这些早期几十年,并以我们如何应对数据收集与滥用的挑战来评判我们。

我们应努力让他们感到骄傲。

立法与自律

数据保护法也许能够帮助维护个体权利。例如,欧盟 GDPR 规定,个人数据必须“为特定、明确且合法的目的而收集,不得以与这些目的不相容的方式进一步处理”;并且数据必须“就处理目的而言充分、相关且限于必要范围” 32。

然而,这一 数据最小化 原则与大数据哲学正面冲突。大数据强调最大化数据收集,把数据与其他数据集合并,持续实验与探索,以产生新洞见。探索意味着为预见之外的目的使用数据,这与“特定且明确目的”正相反。尽管 GDPR 对在线广告行业产生了一些影响 45,监管执行总体仍偏弱 46,也似乎没有在更广泛的科技行业内真正带来文化与实践层面的显著转变。

那些收集大量个人数据的公司把监管视为负担和创新阻碍。这种反对在某种程度上也有其合理性。比如共享医疗数据时,隐私风险确实明确存在,但也有潜在机会:如果数据分析能帮助我们实现更好的诊断或找到更好的治疗方案,能减少多少死亡 47?过度监管可能会阻碍这类突破。如何平衡机会与风险并不容易 41。

归根结底,科技行业需要在个人数据问题上完成一次文化转向。我们应停止把用户当作可优化指标,记住他们是应被尊重、拥有尊严与主体性的人。我们应通过自律来约束数据收集与处理实践,以建立并维系依赖我们软件的人们的信任 48。并且,我们应主动教育终端用户其数据如何被使用,而不是把他们蒙在鼓里。

我们应允许每个个体保有其隐私——也就是对自身数据的控制——而不是通过监视把这种控制偷走。个体对自身数据的控制权,就像国家公园中的自然环境:如果我们不明确保护并照料它,它就会被破坏。这会成为“公地悲剧”,最终所有人都更糟。无处不在的监视并非命中注定——我们仍有机会阻止它。

第一步是不要无限期保留数据,而应在不再需要时尽快清除,并在源头最小化收集 48, 49。只要你的数据不存在,它就不会被泄露、被盗,或被政府强制交出。总的来说,这需要文化与态度的改变。作为技术从业者,如果我们不考虑自己工作的社会影响,那就是没有尽到本职 50。

总结

至此,本书接近尾声。我们已经走过了很长一段路:

在 第 1 章 中,我们对比了分析型系统与事务型系统,比较了云与自托管,权衡了分布式与单节点系统,并讨论了如何平衡业务需求与用户需求。

在 第 2 章 中,我们看到了如何定义非功能性需求,例如性能、可靠性、可伸缩性与可维护性。

在 第 3 章 中,我们考察了从关系模型、文档模型到图模型的一系列数据模型,也讨论了事件溯源与 DataFrame。我们还看了多种查询语言示例,包括 SQL、Cypher、SPARQL、Datalog 与 GraphQL。

在 第 4 章 中,我们讨论了面向 OLTP 的存储引擎(LSM 树与 B 树)、面向分析的存储(列式存储),以及面向信息检索的索引(全文检索与向量检索)。

在 第 5 章 中,我们考察了将数据对象编码为字节的不同方式,以及如何在需求变化时支持演化。我们还比较了进程间数据流动的几种方式:经由数据库、服务调用、工作流引擎或事件驱动架构。

在 第 6 章 中,我们研究了单领导者、多领导者与无主(无领导者)复制之间的权衡,也讨论了写后读一致性等一致性模型,以及可让客户端离线工作的同步引擎。

在 第 7 章 中,我们深入讨论了分片,包括再平衡策略、请求路由与次级索引。

在 第 8 章 中,我们覆盖了事务:持久性、各种隔离级别(读已提交、快照隔离、可串行化)的实现方式,以及如何在分布式事务中保证原子性。

在 第 9 章 中,我们梳理了分布式系统中的基础问题(网络失效与延迟、时钟误差、进程暂停、崩溃),并看到这些问题如何让“实现一个看似简单的锁”都变得困难。

在 第 10 章 中,我们深入分析了各种共识形式,以及它所支持的一致性模型(线性一致性)。

在 第 11 章 中,我们深入批处理,从简单的 Unix 工具链一直讲到基于分布式文件系统或对象存储的大规模分布式批处理系统。

在 第 12 章 中,我们把批处理推广到流处理,讨论了底层消息代理、数据变更捕获、容错机制,以及流连接等处理模式。

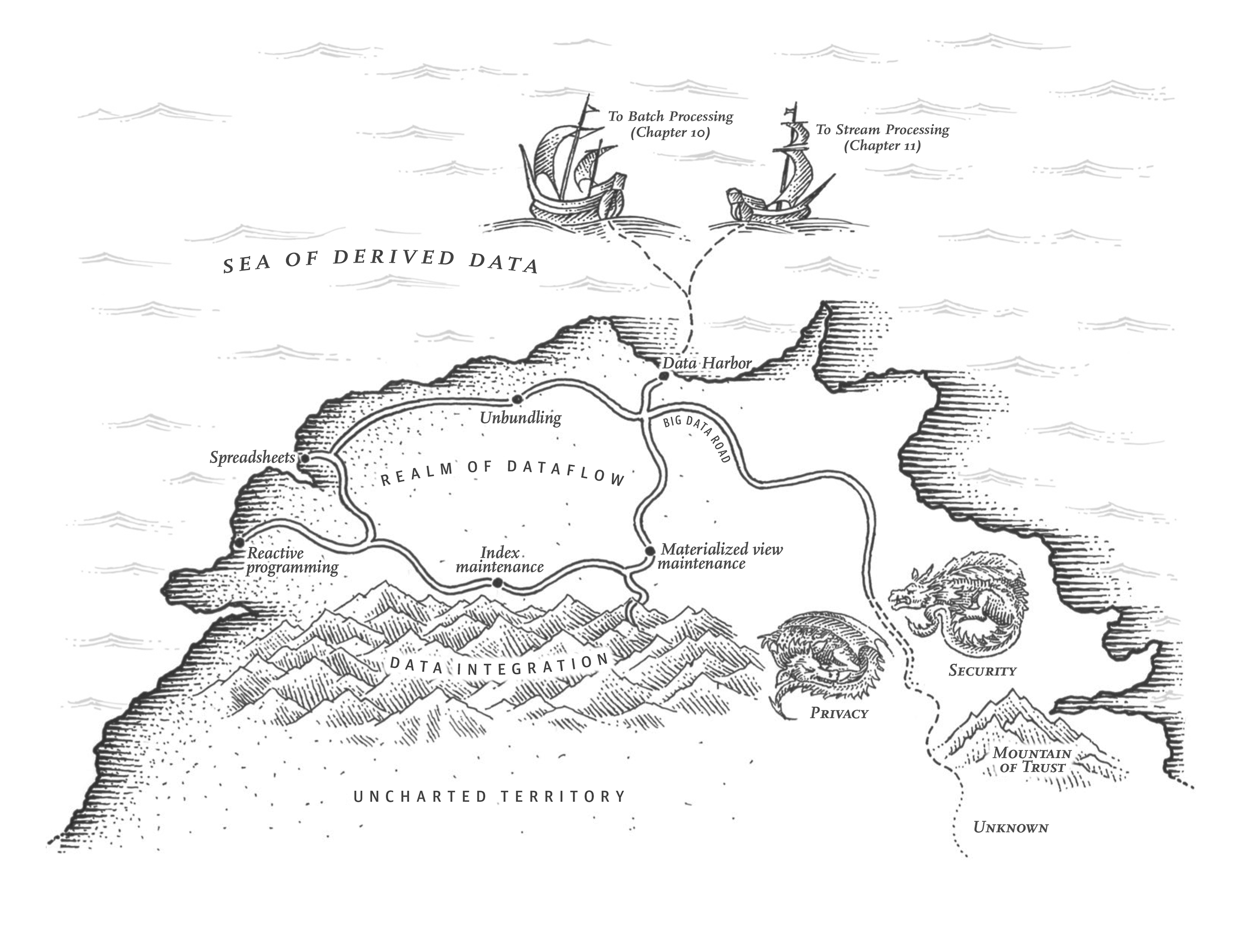

在 第 13 章 中,我们探讨了流式系统的一种哲学,它使异构数据系统更易于集成、系统更易于演化、应用更易于扩展。

最后,在本章中,我们后退一步,审视了构建数据密集型应用的一些伦理面向。我们看到,数据虽可为善,也可能造成严重伤害:作出深刻影响个人生活却难以申诉的决策,导致歧视与剥削,使监视常态化,并暴露私密信息。我们还面临数据泄露风险,也可能发现某些出于善意的数据使用产生了非预期后果。

随着软件与数据对世界产生如此巨大的影响,我们作为工程师必须记住:我们有责任朝着我们希望生活其中的世界努力——一个以人性与尊重对待人的世界。让我们共同朝这个目标前进。

参考文献

David Schmudde. What If Data Is a Bad Idea?. schmud.de, August 2024. Archived at perma.cc/ZXU5-XMCT ↩︎

ACM Code of Ethics and Professional Conduct. Association for Computing Machinery, acm.org, 2018. Archived at perma.cc/SEA8-CMB8 ↩︎

Igor Perisic. Making Hard Choices: The Quest for Ethics in Machine Learning. linkedin.com, November 2016. Archived at perma.cc/DGF8-KNT7 ↩︎

John Naughton. Algorithm Writers Need a Code of Conduct. theguardian.com, December 2015. Archived at perma.cc/TBG2-3NG6 ↩︎

Ben Green. “Good” isn’t good enough. At NeurIPS Joint Workshop on AI for Social Good, December 2019. Archived at perma.cc/H4LN-7VY3 ↩︎

Deborah G. Johnson and Mario Verdicchio. Ethical AI is Not about AI. Communications of the ACM, volume 66, issue 2, pages 32–34, January 2023. doi:10.1145/3576932 ↩︎

Marc Steen. Ethics as a Participatory and Iterative Process. Communications of the ACM, volume 66, issue 5, pages 27–29, April 2023. doi:10.1145/3550069 ↩︎

Logan Kugler. What Happens When Big Data Blunders? Communications of the ACM, volume 59, issue 6, pages 15–16, June 2016. doi:10.1145/2911975 ↩︎

Miri Zilka. Algorithms and the criminal justice system: promises and challenges in deployment and research. At University of Cambridge Security Seminar Series, March 2023. ↩︎

Bill Davidow. Welcome to Algorithmic Prison. theatlantic.com, February 2014. Archived at archive.org ↩︎

Don Peck. They’re Watching You at Work. theatlantic.com, December 2013. Archived at perma.cc/YR9T-6M38 ↩︎

Leigh Alexander. Is an Algorithm Any Less Racist Than a Human? theguardian.com, August 2016. Archived at perma.cc/XP93-DSVX ↩︎

Jesse Emspak. How a Machine Learns Prejudice. scientificamerican.com, December 2016. perma.cc/R3L5-55E6 ↩︎

Rohit Chopra, Kristen Clarke, Charlotte A. Burrows, and Lina M. Khan. Joint Statement on Enforcement Efforts Against Discrimination and Bias in Automated Systems. ftc.gov, April 2023. Archived at perma.cc/YY4Y-RCCA ↩︎

Maciej Cegłowski. The Moral Economy of Tech. idlewords.com, June 2016. Archived at perma.cc/L8XV-BKTD ↩︎

Greg Nichols. Artificial Intelligence in healthcare is racist. zdnet.com, November 2020. Archived at perma.cc/3MKW-YKRS ↩︎

Cathy O’Neil. Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy. Crown Publishing, 2016. ISBN: 978-0-553-41881-1 ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

Julia Angwin. Make Algorithms Accountable. nytimes.com, August 2016. Archived at archive.org ↩︎

Bryce Goodman and Seth Flaxman. European Union Regulations on Algorithmic Decision-Making and a ‘Right to Explanation’. At ICML Workshop on Human Interpretability in Machine Learning, June 2016. Archived at arxiv.org/abs/1606.08813 ↩︎

A Review of the Data Broker Industry: Collection, Use, and Sale of Consumer Data for Marketing Purposes. Staff Report, United States Senate Committee on Commerce, Science, and Transportation, commerce.senate.gov, December 2013. Archived at perma.cc/32NV-YWLQ ↩︎ ↩︎

Stephanie Assad, Robert Clark, Daniel Ershov, and Lei Xu. Algorithmic Pricing and Competition: Empirical Evidence from the German Retail Gasoline Market. Journal of Political Economy, volume 132, issue 3, pages 723-771, March 2024. doi:10.1086/726906 ↩︎

Donella H. Meadows and Diana Wright. Thinking in Systems: A Primer. Chelsea Green Publishing, 2008. ISBN: 978-1-603-58055-7 ↩︎

Daniel J. Bernstein. Listening to a “big data”/“data science” talk. Mentally translating “data” to “surveillance”: “...everything starts with surveillance...” x.com, May 2015. Archived at perma.cc/EY3D-WBBJ ↩︎

Marc Andreessen. Why Software Is Eating the World. a16z.com, August 2011. Archived at perma.cc/3DCC-W3G6 ↩︎

J. M. Porup. ‘Internet of Things’ Security Is Hilariously Broken and Getting Worse. arstechnica.com, January 2016. Archived at archive.org ↩︎

Bruce Schneier. Data and Goliath: The Hidden Battles to Collect Your Data and Control Your World. W. W. Norton, 2015. ISBN: 978-0-393-35217-7 ↩︎ ↩︎ ↩︎

The Grugq. Nothing to Hide. grugq.tumblr.com, April 2016. Archived at perma.cc/BL95-8W5M ↩︎

Federal Trade Commission. FTC Takes Action Against General Motors for Sharing Drivers’ Precise Location and Driving Behavior Data Without Consent. ftc.gov, January 2025. Archived at perma.cc/3XGV-3HRD ↩︎

Tony Beltramelli. Deep-Spying: Spying Using Smartwatch and Deep Learning. Masters Thesis, IT University of Copenhagen, December 2015. Archived at arxiv.org/abs/1512.05616 ↩︎

Shoshana Zuboff. Big Other: Surveillance Capitalism and the Prospects of an Information Civilization. Journal of Information Technology, volume 30, issue 1, pages 75–89, April 2015. doi:10.1057/jit.2015.5 ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

Michiel Rhoen. Beyond Consent: Improving Data Protection Through Consumer Protection Law. Internet Policy Review, volume 5, issue 1, March 2016. doi:10.14763/2016.1.404 ↩︎

Regulation (EU) 2016/679 of the European Parliament and of the Council of 27 April 2016. Official Journal of the European Union, L 119/1, May 2016. ↩︎ ↩︎

UK Information Commissioner’s Office. What is the ’legitimate interests’ basis? ico.org.uk. Archived at perma.cc/W8XR-F7ML ↩︎

Tristan Harris. How a handful of tech companies control billions of minds every day. At TED2017, April 2017. ↩︎

Carina C. Zona. Consequences of an Insightful Algorithm. At GOTO Berlin, November 2016. ↩︎

Imanol Arrieta Ibarra, Leonard Goff, Diego Jiménez Hernández, Jaron Lanier, and E. Glen Weyl. Should We Treat Data as Labor? Moving Beyond ‘Free’. American Economic Association Papers Proceedings, volume 1, issue 1, December 2017. ↩︎

Bruce Schneier. Data Is a Toxic Asset, So Why Not Throw It Out? schneier.com, March 2016. Archived at perma.cc/4GZH-WR3D ↩︎ ↩︎

Cory Scott. Data is not toxic - which implies no benefit - but rather hazardous material, where we must balance need vs. want. x.com, March 2016. Archived at perma.cc/CLV7-JF2E ↩︎

Mark Pesce. Data is the new uranium – incredibly powerful and amazingly dangerous. theregister.com, November 2024. Archived at perma.cc/NV8B-GYGV ↩︎

Bruce Schneier. Mission Creep: When Everything Is Terrorism. schneier.com, July 2013. Archived at perma.cc/QB2C-5RCE ↩︎

Lena Ulbricht and Maximilian von Grafenstein. Big Data: Big Power Shifts? Internet Policy Review, volume 5, issue 1, March 2016. doi:10.14763/2016.1.406 ↩︎ ↩︎

Ellen P. Goodman and Julia Powles. Facebook and Google: Most Powerful and Secretive Empires We’ve Ever Known. theguardian.com, September 2016. Archived at perma.cc/8UJA-43G6 ↩︎

Judy Estrin and Sam Gill. The World Is Choking on Digital Pollution. washingtonmonthly.com, January 2019. Archived at perma.cc/3VHF-C6UC ↩︎

A. Michael Froomkin. Regulating Mass Surveillance as Privacy Pollution: Learning from Environmental Impact Statements. University of Illinois Law Review, volume 2015, issue 5, August 2015. Archived at perma.cc/24ZL-VK2T ↩︎

Pengyuan Wang, Li Jiang, and Jian Yang. The Early Impact of GDPR Compliance on Display Advertising: The Case of an Ad Publisher. Journal of Marketing Research, volume 61, issue 1, April 2023. doi:10.1177/00222437231171848 ↩︎

Johnny Ryan. Don’t be fooled by Meta’s fine for data breaches. The Economist, May 2023. Archived at perma.cc/VCR6-55HR ↩︎

Jessica Leber. Your Data Footprint Is Affecting Your Life in Ways You Can’t Even Imagine. fastcompany.com, March 2016. Archived at archive.org ↩︎

Maciej Cegłowski. Haunted by Data. idlewords.com, October 2015. Archived at archive.org ↩︎ ↩︎

Sam Thielman. You Are Not What You Read: Librarians Purge User Data to Protect Privacy. theguardian.com, January 2016. Archived at archive.org ↩︎

Jez Humble. It’s a cliché that people get into tech to “change the world”. So then, you have to actually consider what the impact of your work is on the world. The idea that you can or should exclude societal and political discussions in tech is idiotic. It means you’re not doing your job. x.com, April 2021. Archived at perma.cc/3NYS-MHLC ↩︎